弊社の研究開発は、先駆的な 3D AIモデルに焦点を当てており、畳み込みニューラル ネットワーク (CNN)、グラフ畳み込みネットワーク (GCN)、トランスフォーマー、物理学に基づくニューラル ネットワーク (PINNs) などの最先端技術を活用して、3D形状認識における画期的な進歩を実現します。

ディープラーニング技術で画像を認識するAIモデルには畳み込みニューラルネットワーク(CNN: Convolutional Neural Network)が多用されています。

これは画像のデータ量は多く、CNNの畳み込み、プーリング処理を用いて圧縮しなければ、ニューラルネットワークで計算が難しいためです。

下図の簡単な例では、32かける32、1024画素の画像が20次元の全結合層に圧縮される手順を表現しています。

2次元画像の畳み込みは画像ピクセルの配列を利用しています。下図にように画像ピクセルの配置が固定されているため、固定された形状とサイズのフィルターで畳み込みが可能です。

私たちが研究開発している3次元形状認識技術も2次元画像と同じく畳み込み技術が必要です。

3次元形状は、3DCADや3Dスキャナーなどで作成される立体形状です。

3DCADが普及する以前の設計データは2次元の図面データでしたが、いまや設計データは、高さ、幅、奥行きの3次元を持った立体形状のまま保管され、様々な用途に利用されています。

これらの立体形状は、それぞれの節点(頂点)位置にX、Y、Zの座標値を持つデータです。

この節点位置と節点間のつながりを把握することで、AIは形状の特徴と寸法を認識することができます。

3D AIによる認識の過程で3次元形状の畳み込み技術が使用されています。

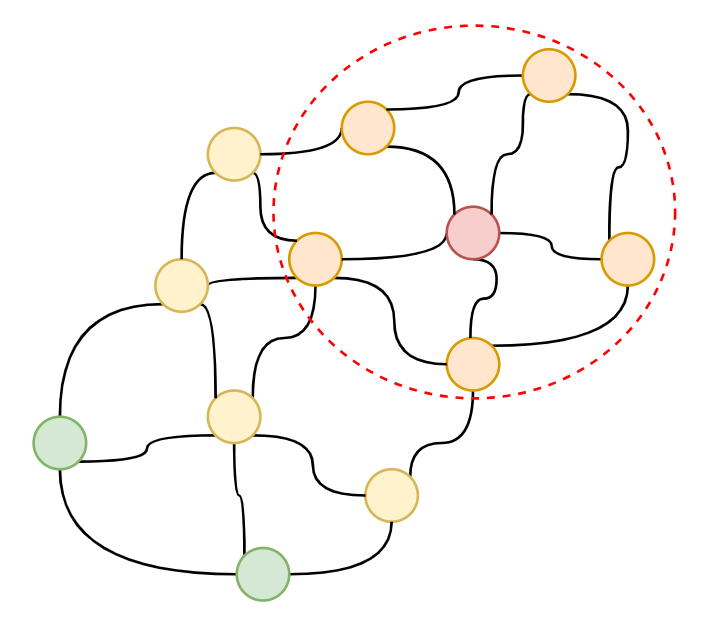

先に述べた3次元形状データを詳しく見ると、下図のように節点間ネットワークの数が固定されていないため、2次元画像と同じ固定されたサイズのフィルターが使用できません。

私たちの技術は、この可変のネットワーク構造を畳み込むことを可能にし、それにより効率的に3次元形状をAIに認識させることができます。

Graph Convolutional Networks(GCN)は、固定グリッド上の情報を処理するのではなく、畳み込み演算をグラフの不規則な構造に適応させるという点で、従来の Convolutional Neural Networks(CNN)とは異なります。

一般的な Graph Neural Networks(GNN) とは異なり、GCN はグラフ データ用に設計された特殊な畳み込み演算を通じて、特に隣接ノードの情報を活用します。これにより、GCN はグラフ構造化データ内の関係と依存関係を効果的にキャプチャできます。

特徴集約: GCN は、ノードの特徴とそのすぐ隣のノードの特徴を組み合わせることで、隣接ノードからの情報を集約します。これは、平均化、加重合計、またはより洗練されたアテンション メカニズムなど、さまざまな方法で実行できます。

特徴変換: 近傍情報を集約した後、GCN は結合された特徴に学習可能な変換を適用します。この変換は多くの場合、単純な線形レイヤーとして実装され、ネットワークがノードとその近傍との間の複雑な関係を学習できるようにします。

より深い理解のためのレイヤーの積み重ね: 従来の CNN と同様に、GCN は複数のレイヤーに積み重ねることができます。各レイヤーはより広い近傍からの情報を集約し、ネットワークがグラフ内のより高次の関係を取得できるようにします。

分類は畳み込みがゲームチェンジャーとなった主要な領域です。GCN の畳み込みは、ローカル近傍情報を取得してグラフ全体に伝播するのに役立ち、ノードが周囲から「学習」できるようにすることで、ノード分類に優れています。

畳み込みをプーリングと組み合わせると、ネットワークはグラフ構造のグローバル表現を学習できるようになります。これは、グラフ全体を分類するために不可欠です。複数の畳み込み層の後、プーリング操作 (グローバル平均プーリングなど) を使用して、ノードレベルの表現を、グラフ全体を表す単一の固定サイズのベクトルに集約できます。このグラフレベルの表現は、分類に使用されます。

3D AIの応用

開発された3D AIモデルは、形状の特徴を認識し指定されたグループに分類するクラス分け、形状だけでなく寸法を含めたマッチング、複数の形状の特徴を混合し新しい形状を生成する新形状合成などの機能に応用できます。

トランスフォーマーは、データのシーケンスを理解して操作するのに非常に優れたニューラル ネットワーク アーキテクチャの一種です。トランスフォーマーが登場する前は、LSTM や GRU などのリカレント ニューラル ネットワーク (RNN) が、シーケンシャル データ (テキスト、時系列、ポイントなど) を処理するための主要なアーキテクチャでした。そのため、生成モデル、要約テキスト、翻訳などのタスクに最適です。

トランスフォーマーは「Attention」と呼ばれるものを使用します。これは、並列処理を可能にする「Attention メカニズム」によってシーケンス モデリングに革命をもたらし、トランスフォーマーを高速化し、シーケンスの異なる部分が離れていてもそれらの間の関係を取得できるようにします。

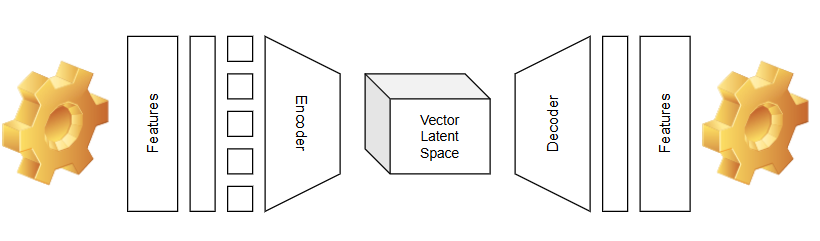

トランスフォーマーは、アーキテクチャの目的に応じて、エンコーダー・デコーダー アーキテクチャを使用してモデルをトレーニングすることがよくあります (常にそうとは限りません)。最初に、入力はデータの本質と関係性を捉えたベクトルに埋め込まれます。次に、位置エンコーディングが適用され、入力から構造、形状、または順序の特徴が抽出されます。Self-Attention や Multi-Head Attention などの主要コンポーネントを含む複数のレイヤーで構成されるエンコーディング スタックは、入力から複雑な特徴を捉えます。最後に、エンコーダーと同様の構造を持ちますが、目的が異なるデコーダーは、エンコーダーによって抽出された特徴に基づいて出力を生成します。

トランスフォーマーモデルが私たちの身の回りにあることにお気づきですか? ChatGPT、Gemini Google AI、Bing Copilot を使用している場合は、トランスフォーマーモデル アーキテクチャとやり取りしています。このアーキテクチャは、大規模言語モデル (LLM) と生成 AI モデルの両方の基礎であり、理解と作成の優れた機能を実現します。

3D AI技術のパイオニアである弊社は、トランスフォーマーアーキテクチャを3Dアプリケーションに適用しています。このアーキテクチャを使用して、既存のデータの要素や特徴を組み合わせたり合成したりして新しいデータを作成する生成型AI合成モデルを構築しています。「合成モデルAI」の詳細については、こちらをご覧ください。また、合成技術の製品もあります。

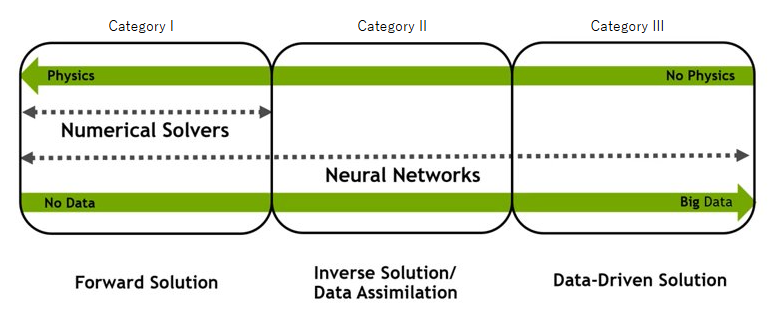

PINNs は、物理法則をアーキテクチャに直接統合するニューラル ネットワークの一種です。つまり、PINNs はデータから学習するだけでなく、問題を支配する基礎となる物理法則からも学習します。従来の AI モデルは「ブラック ボックス」として機能することが多く、選択や結果を説明するのが困難です。しかし、PINNs は物理方程式を組み込んでいるため、物理的な制約に従った結果が生成され、既知の物理法則の範囲内で出力の解釈性と信頼性が向上します。

最近、PINNs はエンジニアリングの世界で大きな注目を集めていますが、PINNs の貢献者の 1 つが NVIDIA であり、NVIDIA Modulus はPINNs を構築、トレーニング、調整するために設計されたオープン ソース フレームワークです。

3D AI テクノロジーのパイオニアである弊社は、3D アプリケーション向けの PINNs の研究でも最前線に立っています。[こちら] で弊社の詳細なレポートをご覧ください。また、シンプルな 3D カンチレバー PINNs のサロゲートモデルを紹介するデモ ページもご覧ください。